O lmarena.ia é uma plataforma colaborativa que reúne diversos modelos de Inteligência Artificial (focados em geração de texto, linguagem natural e outras tarefas avançadas), onde a comunidade pode testar e votar nos resultados de cada modelo. A partir desses votos, cria-se um ranking global dos modelos mais bem avaliados. No momento, o lmarena.ia já conta com mais de 1.555.555 votos acumulados, refletindo a participação ativa da comunidade no refinamento e comparação dos modelos.

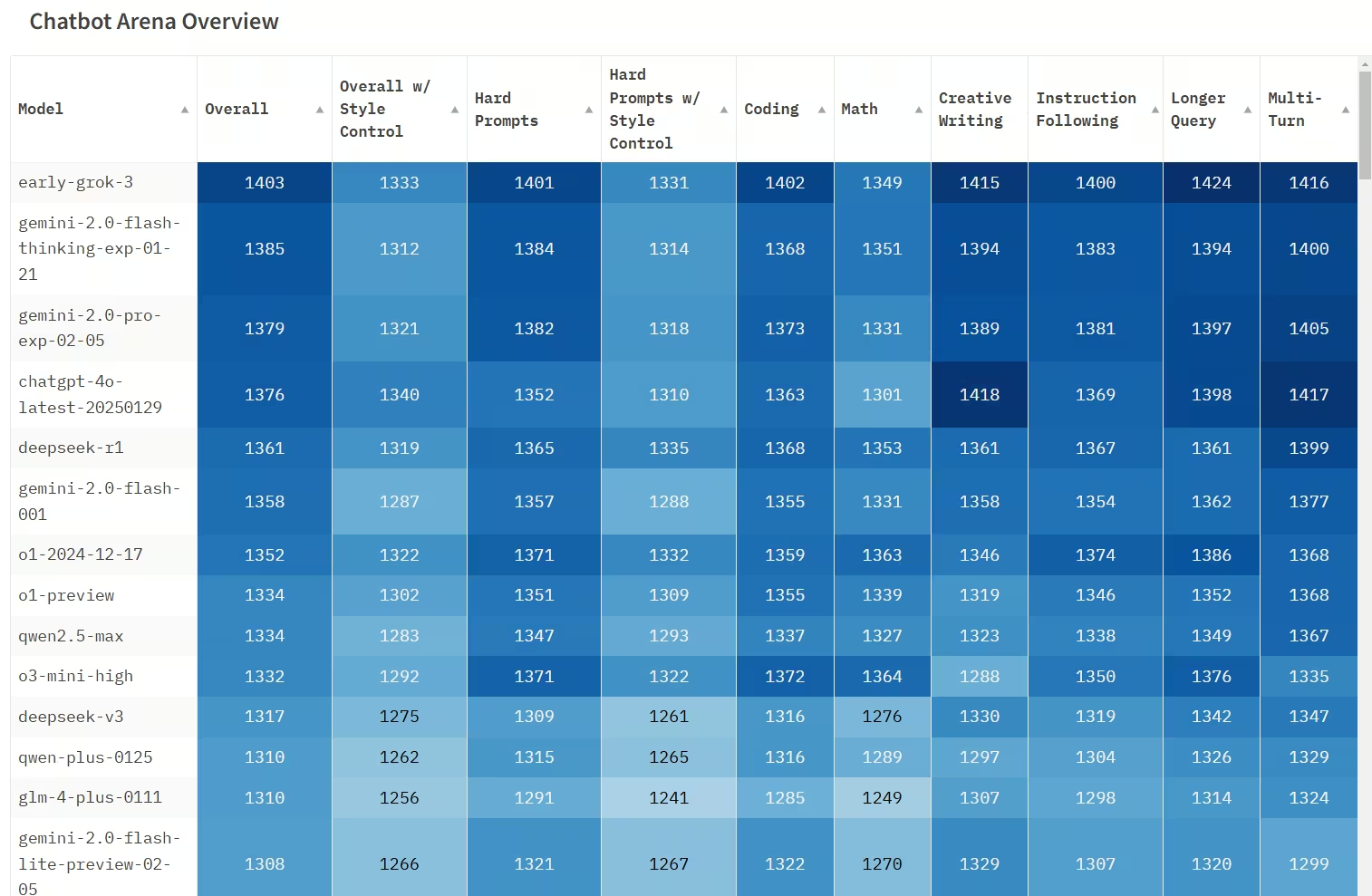

Esta publicação apresenta o Top 10 desses modelos, retirados diretamente do Chatbot Arena Leaderboard e consolidados conforme demonstra o notebook de análise. Cada variável do rank é explicada a seguir, mostrando como os modelos são posicionados, além de uma visão resumida de como o lmarena.ia funciona.

2. Como funciona o lmarena.ia

- Coleta de Resultados

- Usuários interagem com os modelos de IA, fazendo perguntas ou submetendo prompts de teste.

- As respostas são apresentadas lado a lado, de forma anônima (sem identificar qual modelo gerou qual resposta), para evitar viés.

- Votação

- O usuário escolhe a melhor resposta dentre as apresentadas. Cada comparação gera um voto que reflete a preferência do usuário por um determinado modelo.

- Esses votos são armazenados em um sistema de pontuação (ELO ou métrica de classificação semelhante).

- Cálculo do Ranking

- O ranking final combina métricas como consistência, porcentagem de vitórias (win rate), pontuação agregada (ELO) e outras análises estatísticas.

- Quanto mais duelos (comparações) um modelo vence, mais alta é sua posição no ranking.

- Atualização Contínua

- A cada novo voto, as pontuações dos modelos envolvidos podem mudar, resultando em atualizações frequentes no leaderboard.

- Essa dinâmica garante que os resultados reflitam o desempenho atual dos modelos.

3. Variáveis do Ranking

No Top 10 disponibilizado (conforme o leaderboard ), cada coluna ou variável pode ser interpretada da seguinte forma:

- Posição (Rank)

- É a posição do modelo no ranking atual. O modelo de posição 1 é o melhor avaliado no momento, de acordo com o total de votos e métricas.

- Modelo

- Nome ou identificador do modelo na plataforma. Pode incluir a arquitetura-base (por exemplo, GPT, LLaMA, Bloom, Falcon, etc.) e a versão específica.

- ELO

- Sistema inspirado na metodologia de pontuação de xadrez.

- Geralmente, começa de um valor base (como 1200) e sobe ou desce conforme o modelo vence ou perde comparações.

- ELO alto sugere que o modelo vence frequentemente contra outros modelos fortes.

- Win Rate (Porcentagem de Vitórias)

- Representa o percentual de vezes que o modelo foi escolhido em disputas diretas contra outras IAs.

- Win Rate = (Número de vitórias / Número de comparações) x 100%

- Valores acima de 50% indicam que o modelo ganha mais da metade das comparações.

- Total de Votos (ou Comparisons)

- Quantidade de vezes que o modelo participou de duelos (comparações) na plataforma.

- Um número maior de votos indica que o modelo foi testado com maior frequência.

- Consistency Score

- Mede a coerência das respostas do modelo em múltiplos contextos.

- Modelos com pontuação de consistência alta tendem a manter a qualidade independentemente da complexidade ou variação do prompt.

- Pairwise Accuracy

- É a taxa de acertos em comparações diretas com cada um dos outros modelos.

- Pode ser uma média de todas as partidas que o modelo já enfrentou, indicando contra quem ele se sai melhor ou pior.

- Tempo de Resposta ou Speed

- Algumas vezes, a plataforma apresenta métricas de latência ou velocidade de geração de resposta.

- Não é sempre determinante no ranking principal, mas serve como fator secundário para avaliar a usabilidade do modelo.

- Versão / Checkpoint

- Indica se o modelo em questão está em sua versão base, fine-tuned ou se é um checkpoint específico de alguma variante (exemplo: GPT-4.2 vs. GPT-4.3).

- Notas / Observações

- Campo textual livre para comentários da comunidade ou do time de curadoria do lmarena.ia, com insights adicionais sobre comportamento, limitações ou vantagens do modelo.

4. Destaques do Ranking

1. chocolate (Early Grok-3)

- Rank (UB): 1.0

- Arena Score: 1403.0

- Organization: xAI

- Diferenciais:

- Líder absoluto: Com a maior pontuação (1403), este modelo é o melhor avaliado na lista.

- Proprietário: Desenvolvido pela xAI, uma empresa focada em IA de ponta, o que sugere tecnologia avançada e inovadora.

- Alta confiabilidade: Com 9992 votos, a avaliação é robusta e confiável.

- Foco em desempenho: A pontuação alta indica que ele supera outros modelos em tarefas complexas.

2. Gemini-2.0-Flash-Thinking-Exp-01-21

- Rank (UB): 2.0

- Arena Score: 1385.0

- Organization: Google

- Diferenciais:

- Velocidade e eficiência: O nome "Flash" sugere que este modelo é otimizado para respostas rápidas e eficientes.

- Alta pontuação: Com 1385, está muito próximo do líder, indicando um desempenho excepcional.

- Grande número de votos: 15083 votos mostram que ele foi amplamente testado e avaliado.

- Integração com ecossistema Google: Provavelmente integrado a ferramentas como Google Search, Gmail, e outras plataformas da empresa.

3. Gemini-2.0-Pro-Exp-02-05

- Rank (UB): 2.0

- Arena Score: 1380.0

- Organization: Google

- Diferenciais:

- Foco em profissionalismo: O nome "Pro" sugere que este modelo é voltado para tarefas complexas e profissionais.

- Pontuação próxima ao topo: Com 1380, ele é quase tão bom quanto o modelo Flash da Google.

- Versatilidade: Provavelmente capaz de lidar com uma ampla gama de tarefas, desde análise de dados até geração de texto avançada.

4. ChatGPT-4o-latest (2025-01-29)

- Rank (UB): 2.0

- Arena Score: 1377.0

- Organization: OpenAI

- Diferenciais:

- Atualização recente: A data no nome (2025-01-29) sugere que este é um dos modelos mais recentes da OpenAI.

- Desempenho consistente: Com 1377 pontos, ele mantém o alto padrão da OpenAI em modelos de linguagem.

- Grande número de votos: 13470 votos indicam uma avaliação extensa e confiável.

- Foco em usabilidade: Provavelmente otimizado para interações naturais e respostas precisas.

5. DeepSeek-R1

- Rank (UB): 5.0

- Arena Score: 1362.0

- Organization: DeepSeek

- Diferenciais:

- Licença MIT: Diferente da maioria dos modelos proprietários, o DeepSeek-R1 é de código aberto, o que permite maior flexibilidade para desenvolvedores.

- Pontuação sólida: Com 1362, ele compete com modelos de grandes empresas como Google e OpenAI.

- Foco em acessibilidade: Por ser open-source, ele pode ser adaptado para diversas aplicações sem restrições de licenciamento.

6. Gemini-2.0-Flash-001

- Rank (UB): 5.0

- Arena Score: 1358.0

- Organization: Google

- Diferenciais:

- Eficiência operacional: Assim como o outro modelo "Flash", este é provavelmente otimizado para velocidade e eficiência.

- Alta confiabilidade: Com 10862 votos, ele foi amplamente testado.

- Integração com ferramentas Google: Provavelmente funciona bem em conjunto com outras soluções da empresa.

7. o1-2024-12-17

- Rank (UB): 5.0

- Arena Score: 1352.0

- Organization: OpenAI

- Diferenciais:

- Modelo experimental: O nome sugere que este é um modelo em fase de testes ou pré-lançamento.

- Alta pontuação: Com 1352, ele está entre os melhores, mesmo sendo experimental.

- Grande número de votos: 17248 votos indicam que ele foi amplamente avaliado, mesmo em fase de teste.

8. o1-preview

- Rank (UB): 8.0

- Arena Score: 1335.0

- Organization: OpenAI

- Diferenciais:

- Pré-visualização de tecnologia futura: Este modelo provavelmente oferece um vislumbre de recursos que serão lançados em versões futuras.

- Enorme número de votos: Com 33169 votos, ele foi avaliado de forma extensiva, indicando grande interesse da comunidade.

- Desempenho consistente: A pontuação de 1335 mostra que ele é confiável, mesmo sendo uma versão preliminar.

9. Qwen2.5-Max

- Rank (UB): 8.0

- Arena Score: 1334.0

- Organization: Alibaba

- Diferenciais:

- Modelo de ponta da Alibaba: Representa a tecnologia avançada de uma das maiores empresas de tecnologia da China.

- Pontuação competitiva: Com 1334, ele está próximo dos modelos da OpenAI e Google.

- Foco em escalabilidade: Provavelmente otimizado para grandes volumes de dados e aplicações empresariais.

10. o3-mini-high

- Rank (UB): 8.0

- Arena Score: 1332.0

- Organization: OpenAI

- Diferenciais:

- Versão compacta e eficiente: O nome "mini" sugere que este modelo é otimizado para ser leve e rápido, mantendo um bom desempenho.

- Pontuação sólida: Com 1332, ele compete com modelos maiores e mais complexos.

- Foco em usabilidade: Provavelmente voltado para aplicações que exigem respostas rápidas e eficientes.

Atenção

A avaliação colaborativa fornecida pelo lmarena.ia oferece uma excelente forma de comparar modelos de IA em diferentes cenários e tarefas.

As métricas de performance, como ELO e Win Rate, asseguram uma visão objetiva de qual modelo se destaca em disputas diretas.

A comunidade é fundamental para fornecer feedback constante, fazendo com que o ranking seja dinâmico e reflita o estado real da arte.

Com mais de 1 milhão de votos acumulados até a data de hoje (23/02/2025), o ranking do lmarena.ia é um dos indicadores mais robustos de desempenho relativo entre modelos de linguagem.

Agradecimentos

Agradecemos aos mantenedores do lmarena.ia, à comunidade de usuários e desenvolvedores que constantemente testam e avaliam os modelos, e a todos que contribuíram com feedback e análises.

Para mais detalhes ou para acessar o ranking completo, visite:

https://huggingface.co/spaces/lmarena-ai/chatbot-arena-leaderboard